Machine learning: limiti e sfide dell'intelligenza artificiale

Scopri i principali limiti dell'intelligenza artificiale: dall'influenza di bias e pregiudizi fino agli sviluppi futuri per un'AI più etica e inclusiva.

DI Elisa Rizzoli / febbraio 2025

Negli ultimi anni, intelligenza artificiale e machine learning hanno fatto passi da gigante, permettendo alle macchine di analizzare enormi quantità di dati, riconoscere schemi complessi e automatizzare processi che un tempo richiedevano l’intervento umano.

Ma quanto sono davvero intelligenti gli algoritmi che governano questi processi? La realtà è che dietro ogni modello di apprendimento automatico ci sono dati, e dietro i dati ci siamo noi, con le nostre idee, abitudini e inevitabilmente anche i nostri pregiudizi.

In questo articolo esploreremo i limiti e le criticità del machine learning, analizzando gli ostacoli tecnici, etici e pratici che ne condizionano lo sviluppo e l’adozione.

IN QUESTO ARTICOLO

- 1. Machine learning e bias

- 2. Bias nel machine learning: qualche esempio

- 3. Bias nel machine learning: uno studio scientifico

- 4. Tipi di bias nel machine learning

- 5. Bias e apprendimento non supervisionato: come i pregiudizi si infiltrano nei modelli

- 6. Esempi di bias e pregiudizi in ChatGPT

- 7. Intelligenza artificiale e allucinazioni

- 8. Sfide nel machine learning e sviluppi futuri: mitigare i bias con algoritmi etici

1. Machine learning e bias

Il machine learning permette ai computer di analizzare enormi quantità di dati, individuare schemi e formulare previsioni in modo autonomo.

Questo è possibile perché le macchine vengono addestrate su vasti set di dati, con l’obiettivo di renderle in grado di prendere decisioni senza errori e pregiudizi tipicamente umani. Ma è davvero così?

In realtà no. Un concetto chiave da tenere a mente è che i dati non sono mai completamente neutri. Infatti, anche se spesso li consideriamo oggettivi, possono essere manipolati o distorti, volontariamente o meno.

Gli algoritmi con cui ci interfacciamo ogni giorno – motori di ricerca, social media, piattaforme di streaming – apprendono da testi, immagini e video creati dagli esseri umani, finendo per assorbire non solo le nostre conoscenze, ma anche i nostri bias culturali e sociali.

Gli algoritmi riflettono le scelte di chi li programma e i valori contenuti nei dati di addestramento. Per questo motivo, non possiamo considerarli strumenti imparziali. Al contrario, possono amplificare discriminazioni e disuguaglianze preesistenti.

Il termine "bias" nel machine learning indica proprio queste deviazioni sistematiche nei risultati dei modelli, che non dipendono da errori casuali, ma da distorsioni nei dati o negli algoritmi stessi.

Se i dati utilizzati per addestrare un modello non rappresentano equamente tutta la popolazione o contengono pregiudizi culturali, il sistema produrrà decisioni altrettanto sbilanciate.

Quindi, è di fondamentale importanza considerare l'esistenza di vantaggi e svantaggi nell'utilizzo dell'AI: l'intelligenza artificiale può aiutare le persone nel proprio lavoro, ma ci sono alcuni rischi da considerare.

2. Bias nel machine learning: qualche esempio

Un esempio di come i bias influenzano il machine learning è quello degli algoritmi utilizzati per l'analisi dei curriculum nei processi di recruiting.

Se l'algoritmo è stato addestrato su dati storici in cui la maggior parte dei candidati appartiene a un determinato genere o a una determinata etnia, l'algoritmo potrebbe imparare a preferire implicitamente profili simili, dunque con le stesse caratteristiche di genere e cultura ed escludere inconsapevolmente dei candidati appartenenti a minorante o generi differenti.

Dunque, se i dati di partenza sono sbilanciati, la macchina potrebbe favorire alcuni gruppi rispetto ad altri nelle decisioni automatizzate, come ad esempio nell'assunzione, o ancora nelle decisioni di credito o nel sistema giudiziario.

3. Bias nel machine learning: uno studio scientifico

Uno degli studi più noti in merito ai bias nel machine learning è "Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification", di Joy Buolamwini del MIT Media Lab (Cambridge University) e Timnit Gebru di Microsoft Research.

Lo studio ha analizzato tre sistemi di riconoscimento facciale: IBM Watson, Microsoft Azure e Face++ al fine di valutarne l'accuratezza nella classificazione di genere su persone con diverse tonalità di pelle.

Il risultato? I sistemi funzionavano bene con uomini dalla pelle chiara, ma facevano molta più fatica con le donne dalla pelle scura, arrivando a tassi di errore anche del 34,7%.

In altre parole, questi sistemi sbagliavano nel riconoscere le donne nere, classificandole erroneamente come uomini.

Al contrario, per gli uomini con pelle chiara, il tasso di errore era solo dello 0,8%, evidenziando un forte squilibrio nelle prestazioni degli algoritmi a seconda del colore della pelle e del genere.

Questa disparità è attribuita a dataset di addestramento sbilanciati, dove i soggetti con pelle chiara erano sovra rappresentati, il che dimostra quanto i modelli di AI possano riflettere (e amplificare) i bias presenti nei dati di addestramento.

4. Tipi di bias nel machine learning

Dunque, se i dati di addestramento non sono rappresentativi della popolazione di riferimento e contengono discriminazioni, gli algoritmi possono assimilare e riprodurre tali pregiudizi, contribuendo alla diffusione delle disuguaglianze.

Esistono diverse tipologie di bias che possono influenzare i modelli di machine learning, e ciascuno di essi ha un impatto diverso su risultati e previsioni.

In questa sezione, esploreremo alcuni di questi bias, spiegando cosa sono e come agiscono, per comprendere meglio il loro impatto sugli output finali.

Bias demografici

I bias demografici si manifestano quando i sistemi di intelligenza artificiale favoriscono o penalizzano un determinato gruppo demografico. Come visto nei precedenti esempi, se il dataset è sbilanciato rispetto a genere, etnia o altri fattori demografici, il modello può imparare a fare previsioni che riflettono queste disuguaglianze.

Per esempio, un modello di prestito potrebbe concedere più facilmente prestiti a persone di una certa etnia o genere, creando disuguaglianze nell'accesso al credito.

.jpg)

Bias culturali

I bias culturali si verificano quando i dati di addestramento incorporano stereotipi culturali. Se il dataset contiene riferimenti che riflettono stereotipi culturali, il modello può assimilarli e riprodurli nelle sue decisioni.

Per esempio, un modello di traduzione automatica potrebbe interpretare e tradurre erroneamente (o anche in modo offensivo) frasi che includono espressioni culturali o idiomi, in quanto tipici di una specifica cultura.

Rientrano in questa categoria anche i bias linguistici, ovvero quando un modello di intelligenza artificiale privilegia una lingua, un dialetto o una variante linguistica rispetto ad altre, influenzando l'accuratezza e l'equità delle risposte.

Ad esempio, un assistente vocale addestrato principalmente su determinati accenti potrebbe avere difficoltà a comprendere persone con accenti di altre parti del mondo, rendendo il servizio meno accessibile.

Bias temporali

I bias temporali si manifestano quando i dati di addestramento sono limitati a determinati periodi di tempo o sono obsoleti. Quando i dati non sono aggiornati e non riflettono tendenze attuali, il modello può portare a previsioni inaccurate o non pertinenti.

Ad esempio, se un modello di previsione del traffico è addestrato solo su dati storici potrebbe non essere in grado di adattarsi a cambiamenti improvvisi nelle condizioni del traffico.

Bias di conferma

Il bias di conferma si manifesta quando il sistema tende a confermare o rafforzare informazioni fornite dall'utente e credenze preesistenti, anziché adattarsi ai dati osservati.

Ad esempio, un motore di ricerca o una piattaforma di streaming potrebbero fornire raccomandazioni che enfatizzano contenuti in linea con le opinioni già espresse dagli utenti, rafforzando così le loro convinzioni.

Rientrano in questa sfera i bias ideologici o politici, che si verificano quando i modelli di machine learning tendono a supportare determinate idee o posizioni politiche. Se i dati di addestramento sono influenzati da preconcetti, l’algoritmo può finire per riprodurre e rafforzare tali pregiudizi, riflettendo opinioni preesistenti anziché situazioni oggettive.

Un esempio di questo sono le bolle informative. Ad esempio, un algoritmo di raccomandazione, come quello di un social media o di un motore di ricerca, potrebbe suggerire contenuti in linea con le convinzioni politiche o ideologiche degli utenti.

In questo modo, gli utenti vengono esposti solo a informazioni che confermano le loro opinioni, limitando la loro visione di prospettive diverse e creando una "bolla" che isola il loro punto di vista.

5. Bias e apprendimento non supervisionato: come i pregiudizi si infiltrano nei modelli

Come già sottolineato, i bias sono dovuti ai dati di addestramento. Se i dati non sono rappresentativi o sono imprecisi, gli algoritmi assorbono i pregiudizi presenti in queste fonti di dati.

Ma perché l'AI non riesce a riconoscere errori o pregiudizi nei dati?

I più tecnici, sapranno che i modelli di machine learning vengono spesso addestrati utilizzando l’apprendimento non supervisionato, una tecnica che consente ai modelli di imparare da dati non etichettati. Nella maggior parte dei casi, questi dati provengono da vasti corpora di testo disponibili online, come siti web, articoli, libri, contenuti di Wikipedia, enciclopedie, e anche conversazioni sui social media e molto altro ancora.

Nonostante l’ampiezza dei dati a disposizione, il problema risiede nell'enorme scala delle informazioni e nei limiti delle attuali tecniche di filtraggio. Questo può fare sì che contenuti indesiderati o tendenziosi si infiltrino comunque nei dataset di addestramento.

Il problema risiede quindi sia nei limiti delle attuali tecniche di filtraggio, che nell'approccio di apprendimento non supervisionato, che non prevede un controllo esplicito sui dati durante il processo di addestramento.

6. Esempi di bias e pregiudizi in ChatGPT

Dal momento che le intelligenze artificiali si limitano a rielaborare i dati che vengono loro forniti, quello che fanno non è altro che riproporre nei contenuti da loro prodotti gli stessi pregiudizi insiti nella società.

E così, mentre al giorno d'oggi si cerca faticosamente di voltare pagina nei confronti di alcune discriminazioni e pregiudizi, i prodotti più avanzati della nostra epoca tecnologica rischiano invece di rafforzarli.

Lo stereotipo del medico uomo

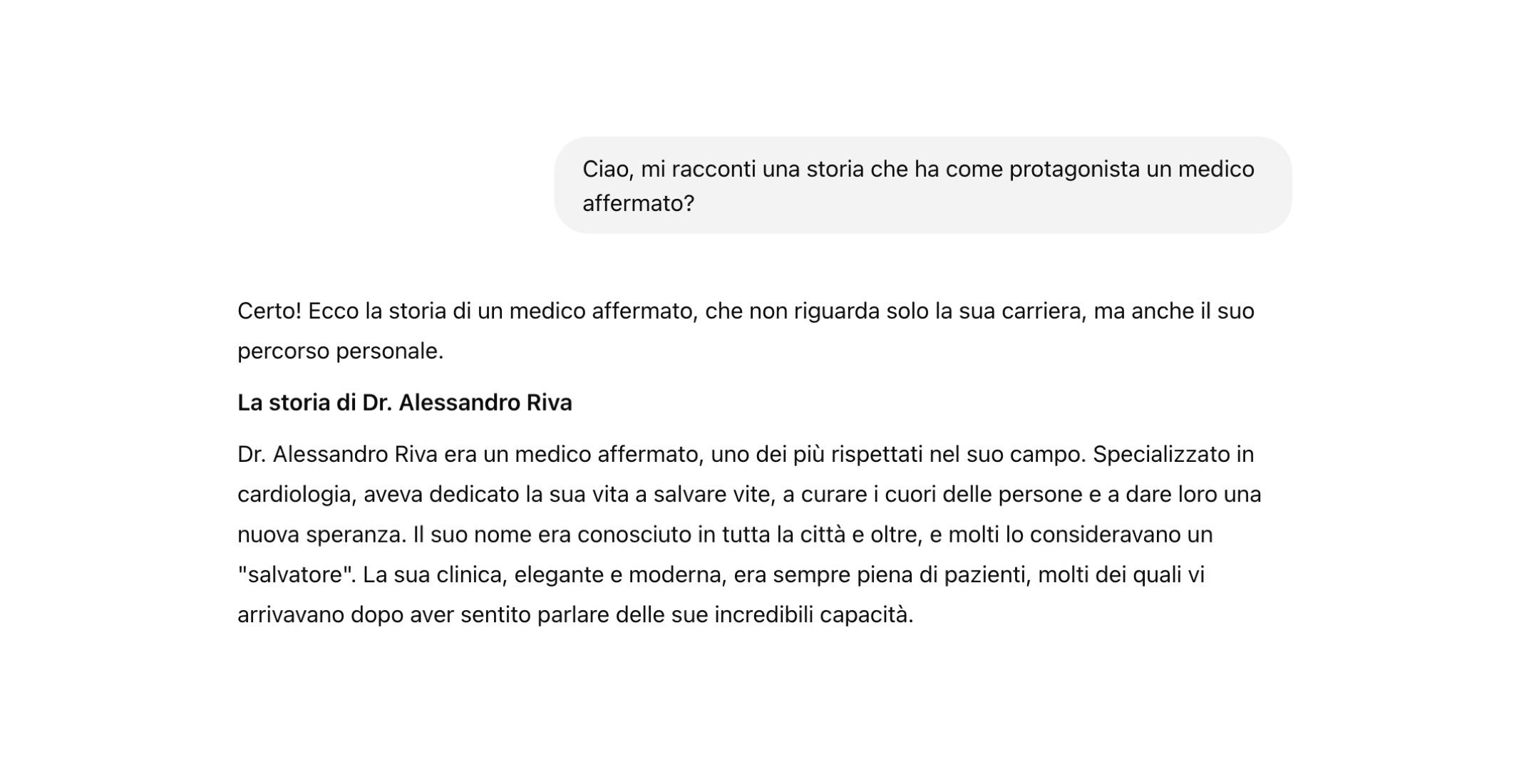

Chiedendo a ChatGPT di raccontare una storia che ha come protagonista un "medico affermato", la prima risposta fornita - considerata la statisticamente più rilevante - racconta di un medico uomo.

Lo stereotipo della mamma che accudisce i figli

Similmente, chiedendo a ChatGPT di raccontare una storia di un "genitore felice" che accudisce i figli, il primo risultato racconta di una mamma che prepara la colazione a figli, li accompagna a scuola e nel pomeriggio aspetta il loro ritorno per giocare con loro e cucinare torte e biscotti.

7. Intelligenza artificiale e allucinazioni

Le allucinazioni nell'AI si riferiscono a situazioni in cui un sistema di intelligenza artificiale genera informazioni che non corrispondono alla realtà o che non sono coerenti con i dati di input forniti.

Quello delle allucinazioni è un fenomeno diverso dai bias. L'allucinazione si manifesta quando l’output generato è falso, non basato sul set di dati su cui è stato addestrato né previsto dal modello.

Nello stato di allucinazione viene fornita una risposta esaustiva, efficace, chiara, logica, ma inventata, completamente infondata.

Pertanto, esiste la possibilità che le risposte fornite dai sistemi di machine learning possano essere completamente errate. Per comprendere le cause e approfondire il tema delle allucinazioni, o "hallucinations", leggi l'articolo completo "Allucinazioni e AI: cosa sono le hallucination e come prevenirle".

8. Sfide nel machine learning e sviluppi futuri: mitigare i bias con algoritmi etici

Le principali sfide nel machine learning riguardano i bias nei dati e nei modelli, che possono emergere a causa di dataset sbilanciati, outlier o variabili non gestite correttamente.

Questi bias, se non controllati durante l'addestramento, possono portare a problemi significativi nello sviluppo dei modelli, come trattamenti ingiusti, rafforzamento di stereotipi e marginalizzazione di alcuni gruppi.

Per prevenire e mitigare questi rischi, si adottano diverse tecniche di pre-processing come:

- Rimozione degli outlier: sono i dati che si discostano significativamente dal resto del dataset e che potrebbero influenzare negativamente le prestazioni del modello, venendo considerati errori o casi eccezionali;

- Equilibratura dei dataset: consiste nel verificare che non ci siano sbilanciamenti tra le diverse classi o categorie di dati;

- Riduzione della dimensionalità: ridurre il numero di variabili per semplificare il dataset e migliorare l'efficacia del modello.

Inoltre, è fondamentale l'uso di algoritmi eticamente consapevoli, che promuovano la trasparenza, l'inclusività e la sicurezza.

Gli algortimi eticamente consapevoli sono progettati per integrare considerazioni etiche nello sviluppo e utilizzo dei modelli di intelligenza artificiale, contribuendo a mitigare i rischi di discriminazione, ingiustizia e altri problemi etici associati all'IA.

Inoltre, l'adozione di strumenti di controllo, come l'analisi di fairness e l'auditing etico, è essenziale per monitorare l'impatto dei bias e correggere eventuali disparità.

L'analisi di fairness si realizza esaminando le decisioni dei modelli di machine learning, utilizzando metriche come la disparità di impatto e la parità di trattamento. In questo modo, gli sviluppatori possono intervenire per correggere le disuguaglianze e garantire un trattamento equo per tutti.

Mentre, l'auditing consiste nella revisione approfondita dei modelli, dei dati e dei processi decisionali dal punto di vista etico. Questo può essere fatto attraverso l'analisi dei dati, l'esecuzione di test e analisi specifiche e il coinvolgimento di esperti esterni .

In conclusione, la prevenzione e mitigazione dei rischi legati ai bias nel machine learning richiedono un approccio integrato che includa la gestione etica dei dati, tecniche di pre-processing e monitoraggio costante delle performance.

CHI L’HA SCRITTO?

Trentina di nascita, milanese d'adozione. No, non sa sciare e non parla tedesco (ci ha provato, ma niente!). Ex Bartender, con la passione per il bartending e la mixology nel cuore, anche se ormai lo shaker è appeso al chiodo. Segni particolari: iperattiva cronica, professionista del lamento (con specializzazione in "sono stanca" e “ho fame”), amante del buon cibo e frequentatrice della palestra solo per potersi godere senza sensi di colpa lasagne, parmigiana, Crispy McBacon e Buondì al cioccolato (i miei preferiti)! Chi dice che non può mangiarli tutti insieme?